Com o avanço e a popularização da inteligência artificial, está cada vez mais difícil detectar e evitar golpes financeiros, o que requer cuidados extras da população, dizem especialistas.

Segundo empresas de cibersegurança, o uso de deep fakes –técnica que usa imagens reais para a criação de outras artificiais– para acessar contas bancárias, por exemplo, já é comum.

“Eles usam um deepfake da face, parecido com um filtro de rede social para validação da biometria”, diz Danilo Barsotti, diretor de tecnologia da idwall, provedora de softwares para bancos.

Além da imagem, alguns golpistas imitam a voz de pessoas conhecidas da vítima, como familiares pedindo dinheiro, ou membros da empresa supostamente autorizando uma transação.

“A IA precisa de apenas três segundos da sua voz para imitar você falando qualquer coisa. E ligam para algum familiar fingindo ser você”, diz Barsotti.

Para conseguir fazer um deep fake, é preciso ter acesso a alguma imagem, vídeo ou áudio da vítima. Para isso, golpistas normalmente acessam redes sociais, usam fotos de documentos furtados, ou ligam se passando por outra pessoa.

É possível encontrar pacotes de dados de possíveis vítimas à venda em grupos no Telegram, bem como instruções de como aplicar o golpe em cada aplicativo. São os chamados “kit bico”. A foto da frente e verso de um documento custa R$ 20. Caso o golpista adquira seis, cada documento sai por R$ 10 a unidade. Já o kit do documento com selfie é anunciado por R$ 150.

“Os fraudadores ganham na escala. Eles não têm apego a banco A, B ou C e estão tentando achar meios de escalar a operação usando deepfake e IA. É visível essa tentativa”, diz Barsotti.

Para Barsotti, foi isso o que teria acontecido com José da Silva, 66. O aposentado teve um empréstimo consignado aprovado em seu nome junto ao Banco Master, apesar de nunca ter sido correntista da instituição.

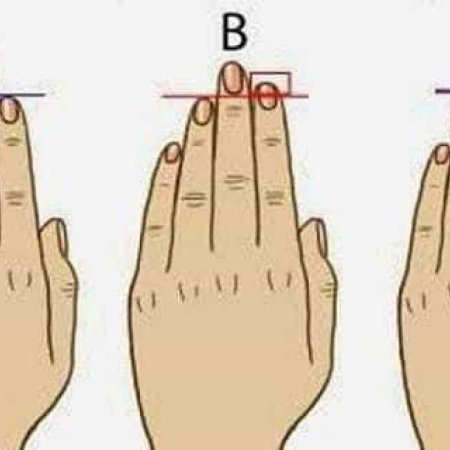

“O golpista deve ter usando uma espécie de filtro para simular características fundamentais no rosto da vítima, como o bigode. As tecnologias mais avançadas de biometria, no entanto, conseguiriam barrar esse tipo de golpe”, diz Barsotti.

De acordo com Silva, a partir de um vazamento de dados, golpistas teriam contratado alguém parecido com ele para validar a biometria junto ao banco e obter o crédito, em janeiro de 2023.

POR FOLHAPRESS

Foto: Shutterstock